«Ich will Chat GPT in meiner Firma, und zwar sofort!» Aber geht das überhaupt?

Die kurze Antwort lautet «JA» und natürlich kommt sogleich auch ein «ABER».

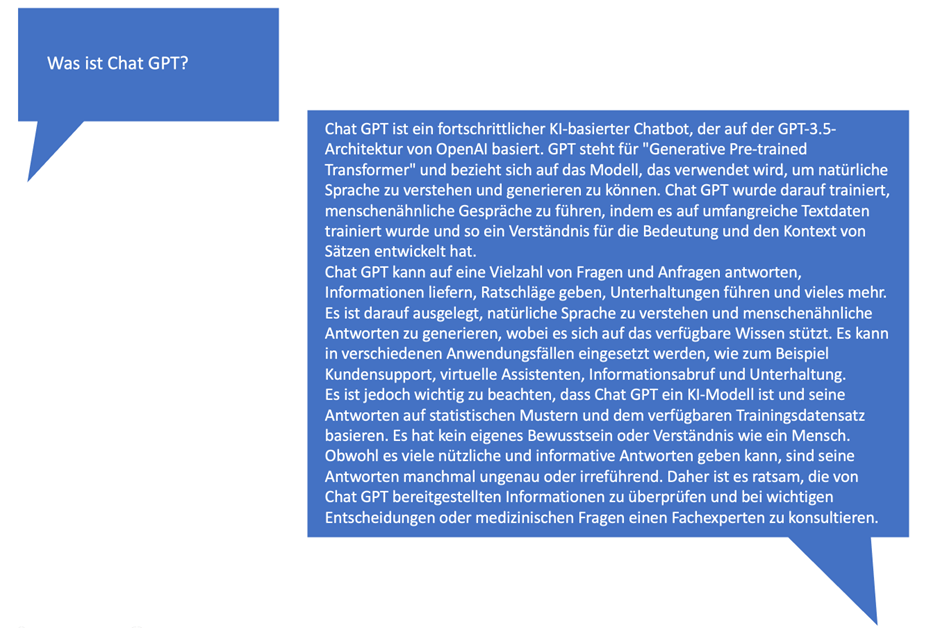

Doch zuerst: Was ist eigentlich Chat GPT

Fragen wir doch gleich mal Chat GPT selbst:

Oh je, eine richtige Plaudertasche.

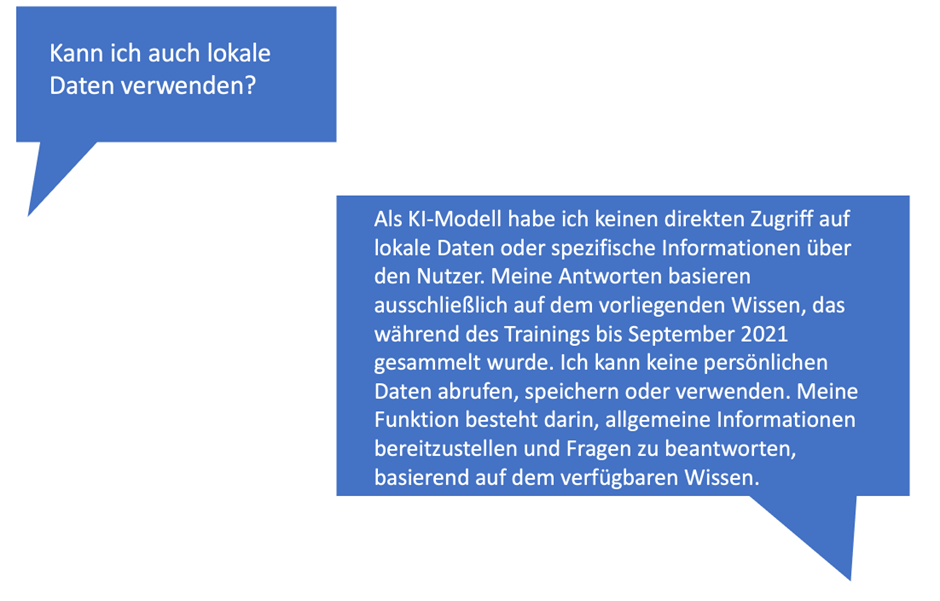

Sehr gut dann wissen wir ja Bescheid, aber können auch lokale Daten miteinbezogen werden?

Fragen wir mal nach:

Das war fast zu befürchten. Open AI, welches die GPT 3.5 Architektur verwendet, kennt nur Daten aus dem Internet (GPT=Generative Pre-trained Transformer). Erschwerend kommt hinzu, dass die Daten das letzte Mal im September 2021 aktualisiert wurden. Dies bedeutet u.a., dass Chat GPT noch keine Ahnung hat, dass die Schweiz an der WM 2023 ausscheiden wird, resp. ausgeschieden wird sein oder so (fühlt sich etwas nach Zeitreise an ...)

Gibt es wirklich keinen Weg, Daten von heute in die Abfragen mit einzubeziehen?

Der erste Satz verrät es schon, doch den gibt es!

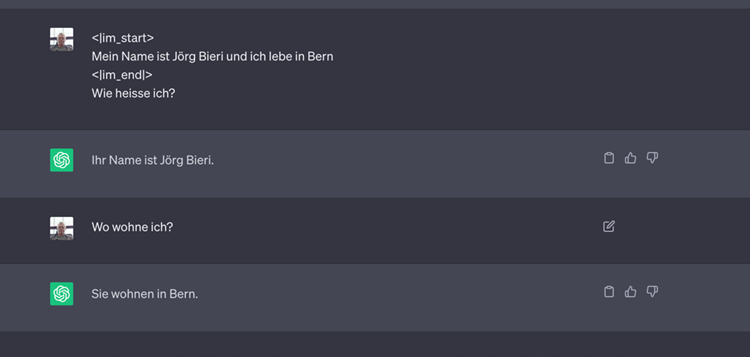

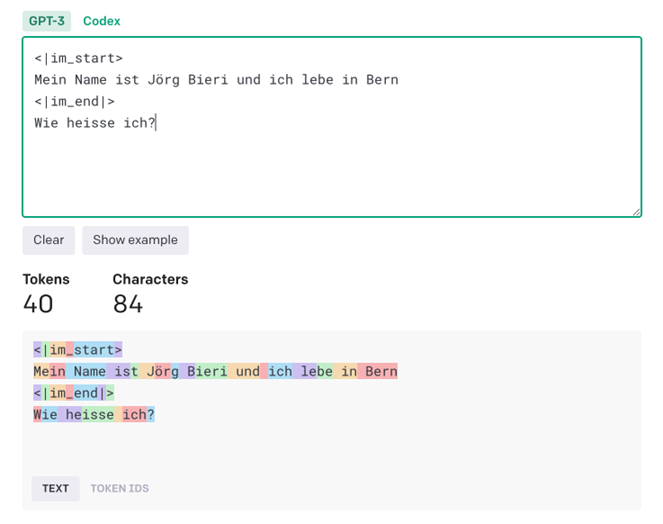

Chat GPT erlaubt es, in der Anfrage eigenes Wissen in Form von Parameter mitzugeben. Konkret geben wir einen Konversationsverlauf mit, den es gar nie gegeben hat.

Das sieht dann ungefähr so aus:

<|im_start>

Mein Name ist Jörg Bieri und ich lebe in Bern

<|im_end|>

Wie heisse ich?

Das Resultat sieht dann folgendermassen aus:

Das heisst also, dass ich in der Anfrage nur Dokumente mitgeben muss und schon funktioniert das Ganze ?

Theoretisch ja, wäre da nicht die Limitation der sogenannten Tokens, welche Chat GPT verarbeiten kann.

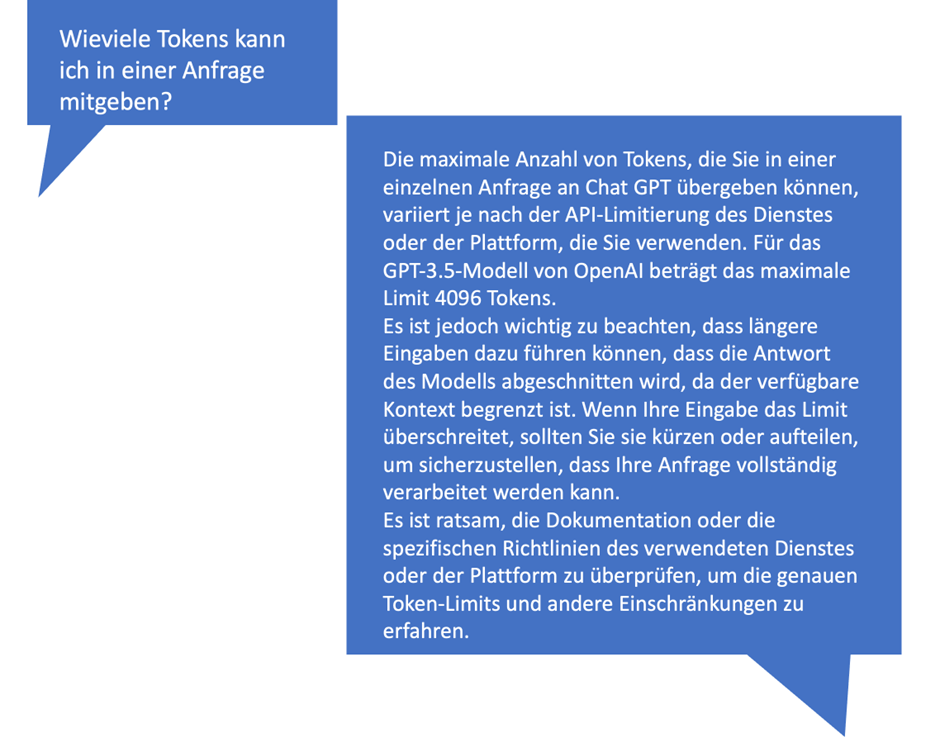

Fragen wir doch mal Chat GPT wo die Limite liegt:

Was heisst denn das nun wieder und was ist ein Token?

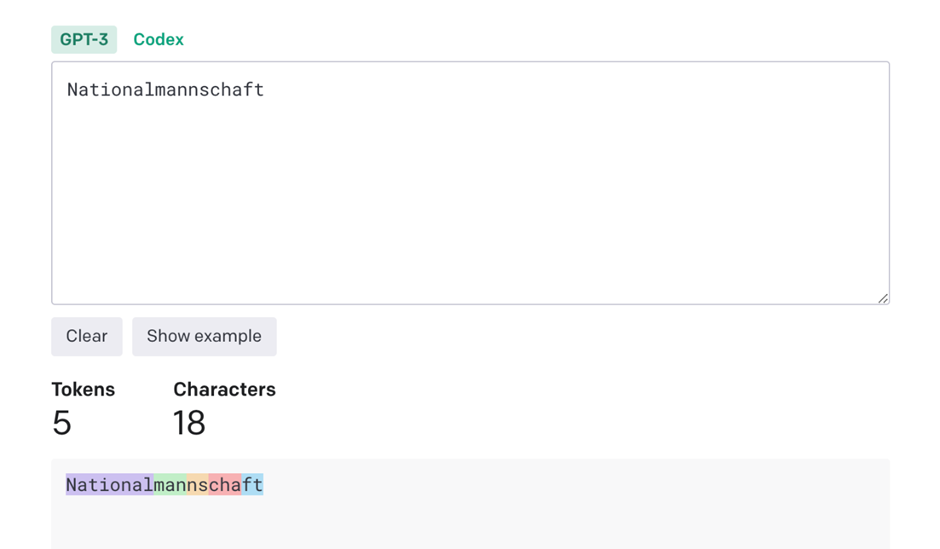

Chat GPT unterteilt eine Anfrage in Tokens, so werden aus dem Wort "Nationalmannschaft"

5 Tokens abgeleitet.

In GPT 3.5 dürfen also 4096 Token mitgegeben werden, was nicht gerade sehr viel ist. Das Namensbeispiel von oben braucht bereits 40 Tokens.

Und genau da ist auch der Hund begraben bei diesem einfachen Lösungsansatz. Die Anzahl der Daten, die mit dem Chatverlauf übergeben werden können, ist ziemlich bescheiden und heisst in der Praxis, dass alle Dokumente in einzelne "junks" zerteilt werden müssen, um sie direkt dem Chat mitgeben zu können.

Aber auch hier gibt es einen alternativen Weg, für welchen wir aber nochmals etwas ausholen müssen.

Möchten wir eine Lösung wie oben beschrieben bauen, wäre es etwas unpraktisch, wenn der User die Basis seiner Anfrage immer gleich selbst zusammenstellen müsste. Hier hilft die Anbindung eines Suchservices, welcher die Basis Dokumente selbständig sucht.

Im Falle von Azure könnte Azure Semantic Search zum Einsatz kommen. Der grosse Vorteil ist, die Suchanfragen in Semantic Search können bereits in natürlicher Sprache ausgeführt werden.

Das Resultat dieser Suchabfrage wären dann Dokumente, welche an Chat GPT übergeben werden könnten. Aber die Originaldokumente müssten auseinandergenommen werden, was irgendwie auch nicht so prickelnd ist.

Aber wie wäre es, wenn die Resultate aus der Suche als Contentpreview direkt weitergeben würde?

Kann klappen, muss aber nicht, da die Resultate i.d.R. nur einen kleinen Ausschnitt der Originaldaten beinhalten und so vermutlich zu wenig Wissen weitergeben würde.

Konklusion

Ihr seht, eine Lösung ist zwar möglich, aber nicht ganz befriedigend. Originaldokumente in einzelne Junks zu zerstückeln ist aufwändig und kann sehr leicht zu Inkonsistenzen führen. Würde ein Originaldokument angepasst, müssten auch die Junks angepasst resp. neu generiert werden.

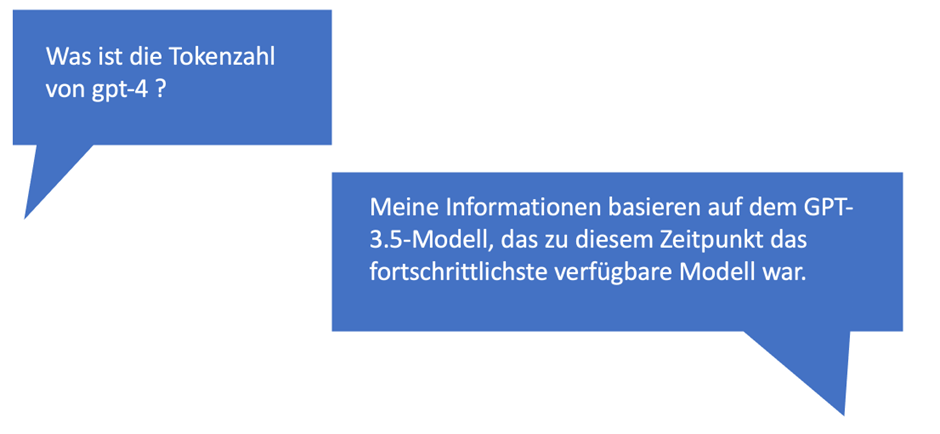

Abhilfe könnten Modelle schaffen welche mehr Tokens verarbeiten. Fragen wir doch nochmals Chat GPT was die Tokenzahl von GPT 4 ist:

Ups, genau, der Infostand ist ja September 2021.

Aber Bing Chat weiss das sicher, werden dort doch auch brandaktuelle Information miteinbezogen:

Ja das hilft sehr und heisst, dass wir wohl demnächst ganze Dokumente in der Anfrage mitgeben können (ja ich weiss bis maximal 50 Seiten), aber das ist doch schon mal ein Anfang ;-)

Auch wenn die Antworten teilweise etwas ernüchternd sind, so würde ich trotzdem schon loslegen und vielleicht ist der Case ja nicht gleich das gesamte DMS das einbezogen werden sollte, sonder eine Datenbank, ein ERP oder sonstige strukturierte Daten, da ist die Menge massiv kleiner, was wiederum heisst, dass der genannte Lösungsansatz funktionieren wird.

Gerne stehe ich euch bei Fragen oder Anmerkungen unter joerg.bieri@garaio.com zur Verfügung.

Jörg

joerg.bieri@garaio.com

+41 58 310 70 60